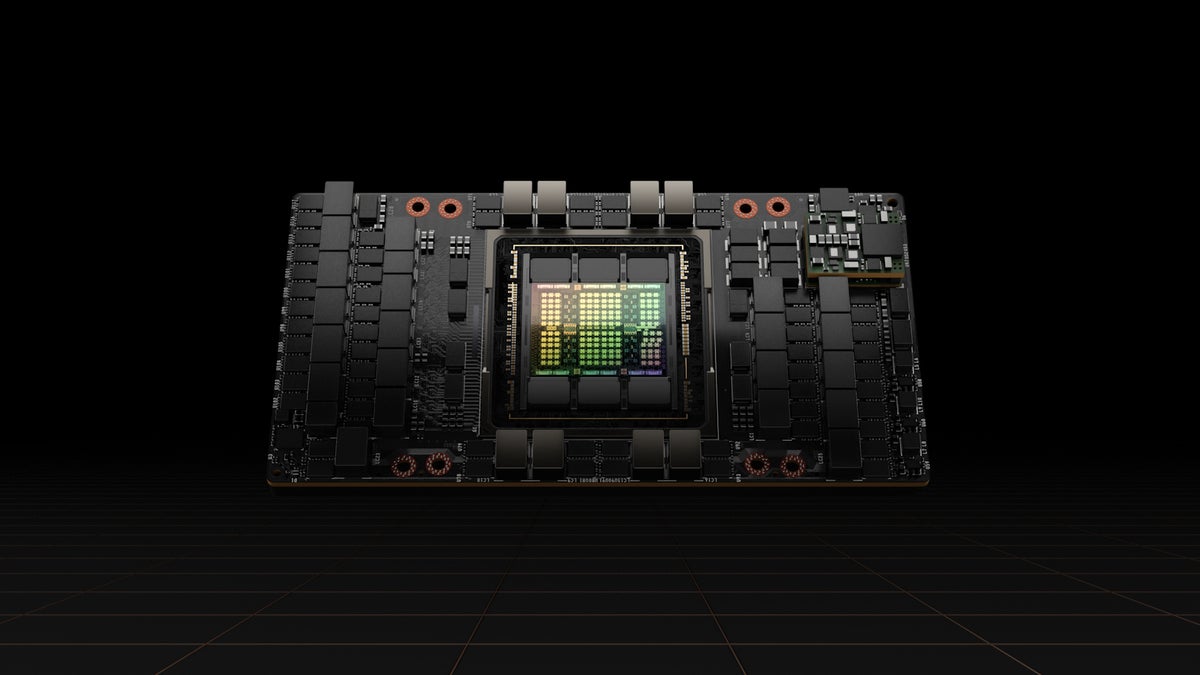

Nvidia今年第二次GTC会议拉开了帷幕,其H100“斗”的一代gpu在全面生产,与全球合作伙伴计划在10月推出的产品和服务,在2023年第一季度的广泛可用性。

料斗功能的创新在安培,其前身架构在2020年推出。最重要的是新的变压器引擎。变形金刚是广泛使用的深度学习模型和标准模型的首选自然语言处理。Nvidia声称H100变压器引擎可以加快神经网络通过6倍安培不失准确性。

斗还带有第二代Nvidia的安全的多实例GPU (MIG)技术,允许一个单一的GPU分割成几个安全分区独立运作和孤立。

也叫做保密的新是一个函数计算、保护人工智能模型和客户数据正在处理时除了保护他们在休息和通过网络在运输途中。最后,料斗的第四代NVLink, Nvidia的高速互连技术,可以连接多达256 H100 gpu在更高的带宽与上一代的9倍。

虽然gpu并不以功率效率,H100使得公司能够提供相同的人工智能性能与能源效率提高3.5倍和3倍比前一代整体拥有成本低,因为企业需要少5 x服务器节点。

“我们的客户正在部署数据中心,基本上是人工智能工厂,生产AIs生产用例。雷竞技电脑网站我们很兴奋地看到H100是什么要做的客户,提供更多的吞吐量,更多的功能和[继续]民主化AI无处不在,”副总裁伊恩·巴克说超大型和HPC Nvidia,媒体和记者的电话。

巴克,他发明了CUDA语言编程Nvidia gpu用于HPC和其他用途,说大型语言模型(llm)将最重要的一个AI H100用例。

语言模型工具训练预测下一个单词一个句子中去,比如手机和浏览器上自动完成。LLM,顾名思义,可以预测整个句子和做更多的事情,比如写论文,创建图表,并生成计算机代码。

“我们看到大型语言模型被用于人类语言之外的事情喜欢编码,并帮助软件开发人员编写软件更快、更有效地用更少的错误,”巴克说。

H100-powered系统从硬件制造商预计将在未来几周内,与50多服务器模型在市场在今年年底在2023年上半年,和许多更多。合作伙伴包括源、思科、戴尔、富士通、g, HPE、联想和超微型计算机。

此外,亚马逊网络服务,谷歌云,微软Azure和甲骨文云基础设施说,他们将成为第一批在云中部署H100-based实例从明年开始。

如果你想给H100测试驱动,它可以通过Nvidia的尝试发射台先试,它的服务,用户可以登录和测试Nvidia硬件,包括H100。