现代图形处理单元(GPU)最初是Windows视频游戏的加速器,但在过去的20年中,已变成了用于高性能计算和人工智能应用程序的企业服务器处理器。

现在,GPU正处于超级计算,AI培训和推理,药物研究,财务建模和医学成像的性能矛尖端。当CPU不够快时,它们也已应用于更多主流任务,如GPU驱动关系数据库。

随着对GPU的需求的增长,供应商之间的竞争也将为服务器制作GPU,只有三个:NVIDIA,AMD和(很快)Intel。英特尔已经尝试并失败了两次,以提出其他人的GPU的替代方案,但正在另一次进行比赛。

GPU在数据中心的重要性雷竞技电脑网站

这三个供应商认识到数据中心对GPU的需求是越来越多的机会。雷竞技电脑网站这是因为GPU比CPU更适合CPU来处理企业数据中心和高标准网络中AI和机器学习所需的许多计算。雷竞技电脑网站CPU可以处理工作;它只需要更长的时间。

因为GPU旨在通过将它们分解为同时执行的单独任务来平行解决复杂的数学问题,因此他们更快地解决了它们。为此,它们具有多个核心,比通用CPU多得多。For example, Intel’s Xeon server CPUs have up to 28 cores, while AMD’s Epyc server CPUs have up to 64. By contrast Nvidia’s current GPU generation, Ampere, has 6,912 cores, all operating in parallel to do one thing: math processing, specifically floating-point math.

GPU的性能是在每秒或flops可以执行的这些浮点数学操作中的数量中测量的。该数字有时会指定制作度量时使用的标准化浮点格式,例如FP64。

那么服务器GPU的一年有什么?事实证明很多。Nvidia,AMD和Intel已经在桌子上放了他们的直接计划,这似乎是一场激烈的竞争。以下是Nvidia,AMD和Intel的商品。

nvidia

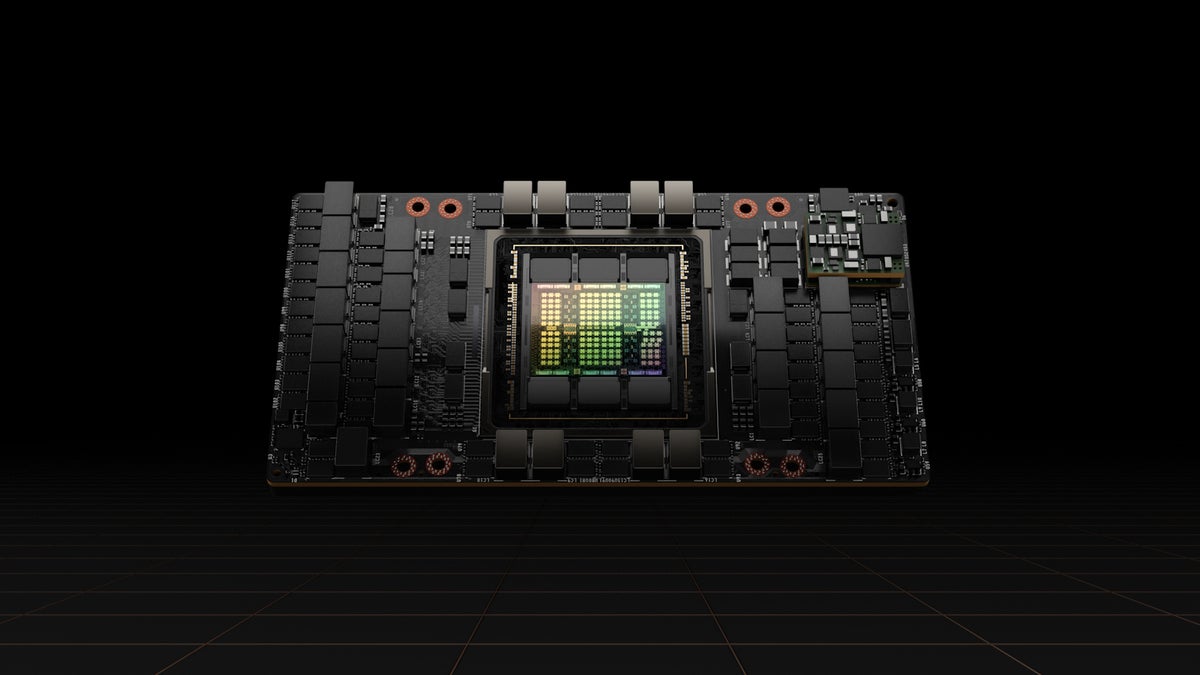

NVIDIA在3月的年度铺设了其GPU路线图,并宣布Hopper GPU建筑声称,根据使用的不同,它可以提供其先前体系结构Ampere的三到六倍,Ampere的体重为9.7 Tflops的FP64。NVIDIA表示,Hopper H100将以60吨FP64的性能排名。

像以前的GPU一样,Hopper H100 GPU可以作为在服务器中的加载项PCI Express板上运行的独立处理器。但是Nvidia也将与CPU配对一个名为Grace的自定义手臂处理器它开发并期望在2023年提供。

对于Hopper来说,Nvidia不仅仅是AMP加强GPU处理器。它还修改了低功率双数据速率(LPDDR)5内存(通常用于智能手机)来创建LPDDR5X。它支持错误校正代码(ECC),并支持传统DDR5存储器的内存带宽两倍,用于1TBPS的吞吐量。

NVIDIA与Hopper一起宣布了NVLink 4,这是其最新的GPU至GPU互连。NVLINK 4C2C允许Hopper GPU直接以最大总带宽为900GBS,比通过PCIE GEN5 BUS连接的速度快了七倍。

“如果您考虑数据中心产品,则有三个组件,它们必须以相同的速度前进。那是记忆,处理器和通信。“而且Nvidia与Hopper一起做到了这一点。这三种技术没有同步,但Nvidia设法做到了。”

NVIDIA计划从2022年第三季度开始运送Hopper GPU。OEM合作伙伴包括ATOS,Boxx Technologies,Cisco,Dell Technologies,Fujitsu,Gigabyte,H3C,H3C,Hewlett Packard Enterprise,Inspur,Inspur,Lenovo,Nettrix和Supermicro。

由于其芯片制造商TSMC持续的供应压力,NVIDIA打开了通往可能与英特尔的铸造业务合作,但警告说,这样的交易将要多年。

amd

AMD的后背有风。销售额增加了季度,其X86 CPU市场份额正在增长,并在2月份完成了对Xilinx及其现场编程的门阵列(FPGA)的收购(FPGA),芯片(SOC),AI发动机和软件专业知识上的自适应系统。预计AMD将在2022年底之前推出其Zen 4 CPU。

AMD基于RDNA 3架构的新游戏GPU也将于今年发布。AMD对RDNA 3规格感到紧张,但是游戏狂欢博客作者散发了未经证实的谣言,即与RDNA 2相比,绩效增长了50%至60%。

同时,AMD已开始运送本能MI250用于企业计算的GPU加速器系列,比以前的MI100系列快得多。内存总线已从4096位翻了一番,增加到8192位,内存带宽已翻了一番,增加了1.23tbps的3.2tbps,并且性能从11.5 Tflops的FP64性能提高到47.9Tflops。这比AMD的Hopper 60Tflops慢,但仍然具有竞争力。

Futurum Research的首席分析师丹尼尔·纽曼(Daniel Newman)表示,随着AI市场的增长,AMD抓住市场份额的机会将出现。他说,他认为AMD在CPU市场上的成功可以帮助其GPU销售。他说:“在过去的五年中,AMD真正创造的是一种非常强烈的忠诚,可能会延续。”“问题是,他们可以大大发展AI/HPC市场份额吗?”

他说,答案可能是“是的”,因为该公司非常擅长寻找市场机会和管理其供应链,以实现其目标。他说,与首席执行官丽莎·苏(Lisa Su)担任掌舵人,“我发现很难在他们决定参加比赛的任何领域排除AMD,”他说。

OMDIA高级计算,AI和IoT的首席分析师Jonathan Cassell表示,他认为AMD在其EPYC服务器CPU中的成功将为本能处理器提供开放。

“我认为,随着时间的流逝,我们可以看到AMD在数据中心的微处理器方面利用了它的成功,并用来让公司来看看[Instinct]。我认为我们会看到AMD试图利用其与客户的关系来试图扩大其存在。”他说。

自第1季度2022年以来,本能一直在运输。到目前为止,其最高的用例是橡树岭国家实验室的超级计算机,将大量的性能挤进了很小的空间。但是,实验室还正在建造一个名为Frontier的全部AMD Exascale超级计算机,该超级计算机将于今年晚些时候部署。OEM合作伙伴本能运输产品包括华硕,ATOS,Dell Technologies,Gigabyte,Hewlett Packard Enterprise(HPE),联想,企鹅计算和Supermicro。

英特尔

长期以来,英特尔一直在为其桌面CPU做出基本的集成GPU而努力。对于台式机,它具有新的Intel XE线,而服务器等效物被称为Intel Server GPU。

现在,该公司表示,今年将使用以处理器代码为ponte Vecchio进入数据中心的GPU领域,据报道,该领域的价格为FP64,与AMD的MI250相同,落后于NVIDIA的Hopper,它的价格为45Tflops。

佩迪说:“这确实会破坏环境。”“从他们告诉我们的事情来看,我们从谣言和其他泄漏中听说过,这是非常可扩展的。”Ponte Vecchio将于今年晚些时候发行。

纽曼还听到了关于庞特·韦奇奥的积极信息,但说英特尔的真正机会是Oneapi软件策略。

Oneapi是该公司正在研究的统一软件开发平台,旨在选择最合适类型的硅英特尔制造(x86,gpu,fpga,fpga,AI处理器),而不是强迫开发人员选择一种类型的硅和代码。它还为视频处理,通信,分析和神经网络等功能提供了许多API库。

这种抽象消除了确定目标最佳处理器的需求,以及使用不同工具,库和编程语言的需求。因此,开发人员不必用特定语言编码特定语言的特定处理器,而可以专注于数据并行C ++(DPC ++),这是C ++的开放源代码变体,专为数据并行性和异质编程而设计。

将英特尔与NVIDIA和AMD分开的一个因素是它制作芯片的地方。尽管其他人使用台湾芯片制造商TSMC,但英特尔在美国制造了许多自己的筹码,并在爱尔兰,马来西亚和以色列制造了其他工厂。在美国制定更多的计划。卡塞尔说,这给它带来了一定的优势。他说:“控制权的控制权以某种方式可以控制其命运。”“我认为这些东西是公司的资产。”

纽曼说,最终,NVIDIA,AMD和英特尔之间的竞争可能归结为软件竞赛。“如果您问[Nvidia]的顶级工程师,他们会说我们不是一家筹码公司。我们是一家软件公司。我确实相信,到目前为止,英特尔并没有真正像软件公司那样想像软件公司,但是如果他们能得到[Oneapi]正确,我在那里看到了一些真正的机会,”他说。