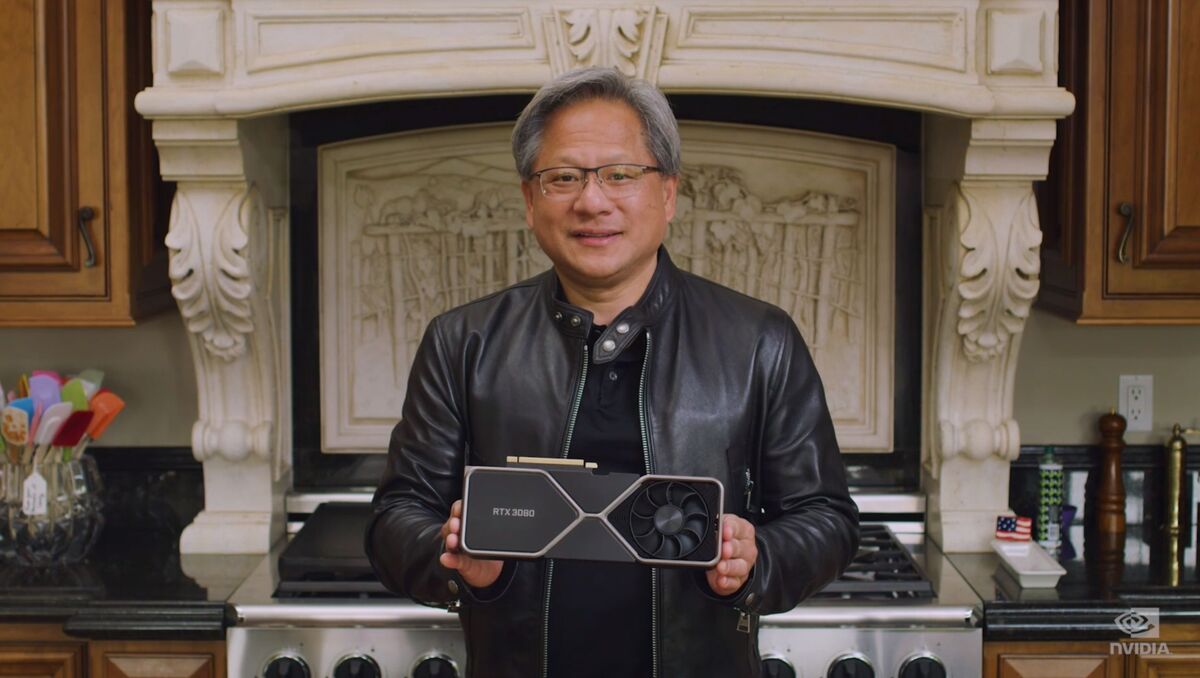

在数十篇新闻稿和博客文章的共同作用下,没人能说英伟达的GPU技术大会(GTC)是一场低调的活动。和去年一样,这次是虚拟的,所以很多消息都来自首席执行官黄仁勋(Jen-Hsun Huang)的厨房。

以下是数据中心人员最关心的一些公告的概要。

两个安培100分钟

NVIDIA的旗舰GPU是去年推出的安培A100。它是一个强大的芯片,适用于超级计算,高性能计算(HPC)和大规模的人工智能(AI)项目,但它也是一些用例和一些钱包的矫枉过正。

因此,GTC公司为其旗舰A100,A30为主流AI和分析服务器的A30介绍了两个小规模的小兄弟,以及混合计算和图形工作负载的A10。两者都以更大,更强大,更能量的A100缩小。

例如,A30支持AI的数学精度以及HPC工作负载(浮点64到ONT4),以及A100的多实例GPU(MIG)分区,但它提供A100的性能一半记忆力较少,核心较少,而不是A100。

NVIDIA的A10也来自A100,但甚至低于A30。例如,它不支持FP64,仅FP32。它还具有GDDR6内存而不是A100上的更快,更昂贵的HBM2。它适用于图形,AI推断和视频编码/解码等工作负载。

英伟达尚未确定这两款卡的发布日期。

DGX出租

它只有意义,如果每个其他硬件OEM都有租约选项,那么nvidia应该。该公司的新型云母超级计算机,NVIDIA DGX站A100,现在可以租赁在短时间内,然后在完成后返回。该计划正式称为NVIDIA金融解决方案(NVFS)。

这是一个明智的举动。橡树岭国家实验室说,个人没有持续的超级计算需求。在许多情况下,他们只需要超短时期的超级计算能力可能一年的几次。因此,多米的美元投资对于可能坐下的硬件没有意义。

NVIDIA还宣布了DGX SuperPod,可使用NVIDIA的Bluefield-2 DPU,实现云原生超级计算机。DGX SuperPod由一堆单独的DGX站电脑组成,其中一个4U架可安装的外形。这是一个完整的裸机超级计算机,因此您提供了操作环境,也可以共享。

芯片路线图

你知道nvidia没有坐在发展上。黄色铺设了即将到来的芯片的路线图,它雄心勃勃。在现在到2025年之间,NVIDIA计划释放六代硬件:两个用于安培,Grace和Bluefield。

“安培下一步”是下一代GPU的代码名称,计划2022版本。有猜测产品名称将是料斗,继续在计算开拓者之后命名GPU架构的传统。与新的恩典CPU配对,这意味着一个NVIDIA系统和GPU将是霍珀他是海军计算机领域的传奇先驱。“安培Next Next”将于2024年或2025年亮相。

Grace将于2023年问世,而“Grace Next”将于2025年问世,而英伟达的Bluefield数据处理单元(DPU)也将有两个新版本;2022年的3号bluefield, 2024年的4号bluefield。英伟达在性能方面做出了巨大的承诺。据称Bluefield-3将比Bluefield-2快10倍,而Bluefield-4将带来100倍的性能提升。

BlueField-3 DPU结合了Arm CPU和网络处理器,将网络处理从CPU中卸下,拥有400Gbps的链路,是当前DPU的5倍Arm计算能力。英伟达表示,BlueField-3 DPU可以提供相当于300个x86 CPU核的数据中心服务。

使用ARM技术

虽然NVIDIA在计划收购ARM持有的扭结时,它正在努力在董事会上提高武器。首先,它宣布将为Amazon Web服务的GPU加速提供GPU加速,AWS自己的基于ARM的处理器。加速的Graviton2实例将提供丰富的游戏流体验,并降低强大的AI推理能力的成本。

在客户端,NVIDIA正在与世界上最大的智能手机筹码供应商联发音,以创建一类由基于ARM-RTX GPU的ARM的CPU提供动力的笔记本电脑。笔记本电脑将使用ARM CoreS和NVIDIA图形,以提供基于支持Chromium,Linux和NVIDIA SDK的参考平台的“无妥协”媒体功能的消费者节能便可。

在边缘计算方面,英伟达正与Marvell半导体公司合作,将其基于OCTEON arm的处理器与英伟达的图形处理器组成团队。它们将共同加速AI工作负载,以实现网络优化和安全。

这只是数据中心新闻。