Nvidia公司,它的遗产在于为玩家制造芯片,宣布了其第一个新GPU架构的三年,它显然是为了有效地支持人工智能和机器学习的各种计算需求。

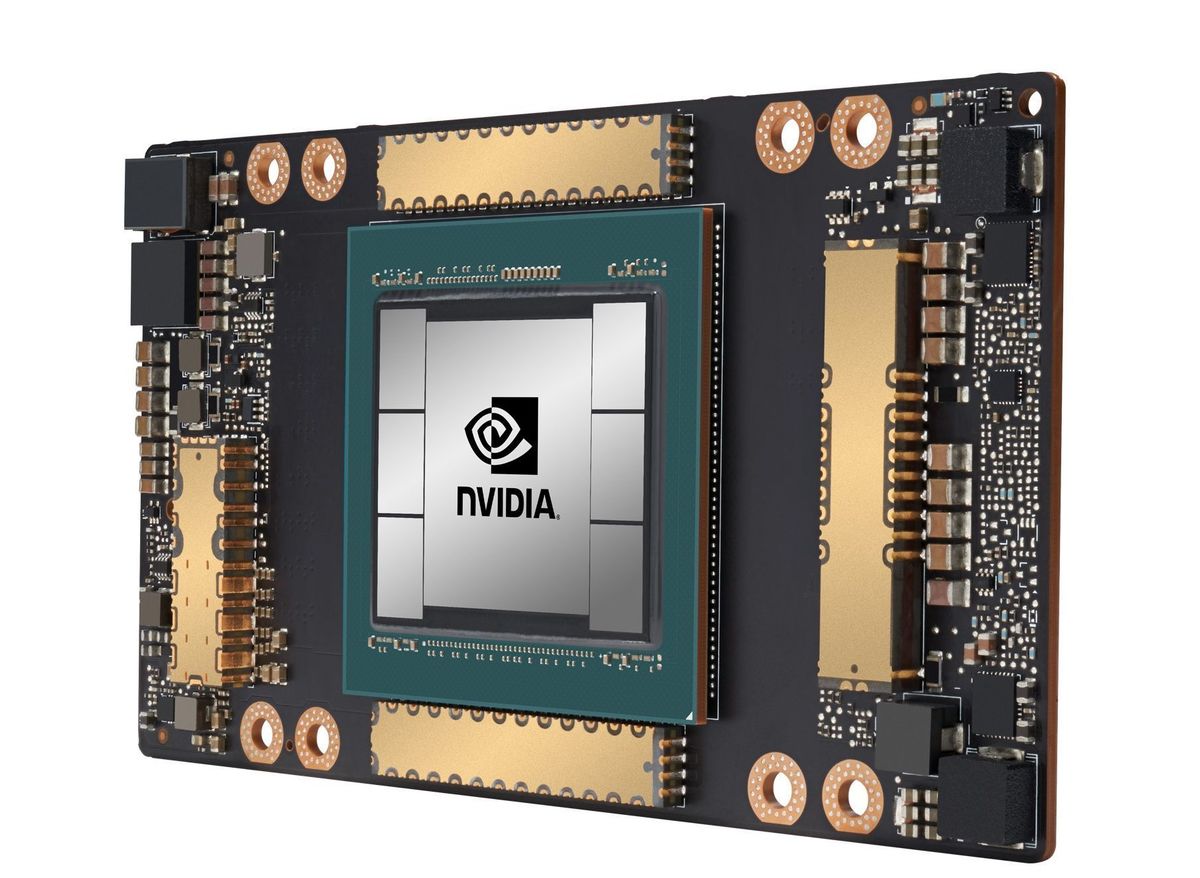

该体系结构,称为安培,而其第一次迭代中,A100处理器,取代Nvidia公司目前的沃尔特架构,其V100芯片是去年11月的超级计算机500强中94的表现。在A100有着令人难以置信的54个十亿个晶体管,2.5倍之多,V100。

张量在人工智能和机器学习中起着至关重要的作用。FP16浮点运算速度几乎是V100的2.5倍,Nvidia引入了一种称为TF32。NVIDIA宣称TF32可以以10倍的加速提供高达相比于沃尔GPU的单精度浮点运算。

这是因为显著FP16是培训,学习机的计算密集型部分是有用的,但矫枉过正推断,在训练的模型被用来推断的结果或结果。所以NVIDIA加入INT8和INT4的A100芯片来处理简单的推理部分,在这个过程中降低功耗。这意味着最佳性能的情况下进行训练和推论从一个单一的芯片。

内存性能也显著提高,因为40GB的HBM2内存在模具上提供了1.6TB/秒的带宽。从A100芯片的外观来看,英伟达做了富士通做的事情A64FX处理器并把HBM2旁边的处理器。

在A100还体育一个叫做多实例GPU(MIG)的新功能,其中单个A100可划分为多达七个虚拟GPU,每个核心得到,L2高速缓存和内存控制器的自己专用的分配。把它看成是虚拟化的GPU。

最后,安配备了Nvidia的高速互连,NVLink的新版本。第三代NVLink的近一倍为NVLink从25.78Gbps上NVLink 2上NVLink 3. Nvidia的50Gbps的信号传输速率还削减了一半以实现相同的速度所需的车道数。这反过来又允许它通过相同数量的通道吞吐量的量加倍。

Nvidia公司CEO詹森黄虚拟GPU技术大会(GTC)时提出通过视频安培宣布从他的厨房。

新卡和服务器已准备好

Nvidia公司是浪费任何时间使A100推向市场。报告说,A100是在生产和宣布DGX A100系统。The box comes with eight A100 accelerators, as well as 15 TB of storage, a pair of AMD Epyc 7742 CPUs with 64 cores each (you didn’t think they were going to use Intel processors, did you?), 1TB of RAM, and HDR InfiniBand Mellanox controllers.

该DGX A100将设置你回到$ 199,000,但它也包5个千万亿次在一个盒子里一个小冰箱大小,都致力于人工智能和机器学习。

此外,NVIDIA的$ 7十亿与Mellanox合并已经结果在EGX A100卡,基于安培-A100 GPU包具有沿着相结合的形式Mellanox连接器X-6 DxNIC一个卡上。

这提供了与网络的200Gbps的A100在无需任何CPU处理,并让A100的GPU直接对话,而不是经过CPU。所有因为GPU到CPU通信这意味着更大的速度的增加步骤,因此等待时间。该卡还可以连接到的Infiniband或以太网架构。在Infiniband GPU到GPU通信手段HPC即将看到性能的主要飞跃。