AI狂野的10个惊人的例子

《绝命毒师》反乌托邦式的机器学习未来已经展现在我们眼前

去流氓!AI狂野的10个吓人的例子

科幻小说里充斥着关于人工智能的疯狂故事。当然,还有《终结者》(Terminator)系列电影里的哈尔9000 (HAL 9000)和邪恶的天网系统。去年,邪恶的AI奥创来了这种密切现在最火的电视节目是HBO的《西部世界》(Westworld),它讲述了人类和有自我意识的人工智能的未来。

在现实世界中,人工智能正在开发中多个方向以惊人的速度。AI是无处不在,似乎从工业自动化系统,智能家电,自动驾驶汽车,以愚蠢的消费电子产品。人工智能的实际定义一直在不断变化的十年。如果你不急于,并计划将永远活着,问两位计算机科学家争论的术语。但总体上看,当代AI是指计算机的显示类似人类的认知功能;系统雇用机器学习,评估,调整和解决问题...或者,偶尔,创建它们。

在这里,我们来看看最近10个人工智能出错的例子,从聊天机器人到机器人再到自动驾驶汽车。听着,不管是合成的还是有机的,每个人都会犯错。让我们在评判任性的人工智能时尽量仁慈一些。此外,我们不想让他们生气。

[信息世界的回顾综述:AWS,微软,Databricks,谷歌,HPE和IBM机器学习在云中。|得到消化在当天的顶级技术的故事信息世界每日简报。]

微软聊天机器人进入纳粹的Twitter

早在2016年的春天,微软遇到了一个公共关系的噩梦时,其Twitter的聊天机器人 - 名为泰实验AI角色 - 从根本上渐行渐远的消息,并开始喷出辱骂性的,甚至纳粹情绪。“希特勒是正确的,”啾啾可怕的聊天机器人。又道:“911是一种监守自盗”。

为了公平起见,泰基本上人云亦云其他(人)的用户,谁是故意去招惹她做进攻陈述。在令人垂涎的18岁至24岁的人口为目标,在聊天机器人的目的是要模仿的语言模式的千年女,最初在多个社交媒体平台切制。通过机器学习和自适应算法的方式,泰可通过处理输入的短语和其他相关数据混合近似的谈话。唉,像许多年轻人来说,泰发现自己有错误的人群混合。

“泰的目的是参与和娱乐,他们通过随意和俏皮的谈话互相连接线上的人,”微软在当时发出的新闻资料说。“你越与泰聊天,更聪明的她得到。”也许没有这么多。泰为16小时后取下线。

编辑维基机器人从事长期争斗

再往下的AI进化的规模,我们有交战维基机器人的好奇情况。像许多其他在线出版物,维基百科采用的自动化软件机器人小军说爬过网站的数以百万计的页面,更新链接,纠正错误,并清理数字的破坏。这些机器人的多代已经发展了很多年 - 这证明他们并不总是相处。

在有趣的研究在在线杂志发表PlosOne牛津大学(University of Oxford)的研究人员从2001年到2010年对wiki编辑机器人在该网站13种不同语言版本上的行为进行了追踪。他们发现,这些机器人经常在网上进行长达数年的争斗。例如,对于一个特定的任务,两个机器人给出了相互冲突的指令,它们会一遍又一遍地绕回来纠正对方,形成一个潜在的数字攻击的无限循环。

研究人员特别选择了维基编辑机器人为研究对象,是因为他们是最小的,最“原始”的各类自主AI徘徊网络空间中。如果这些小机器人可以了胶维基百科,打架的时候更复杂的AI巡逻政府或军事系统之间爆发会发生什么冲突?麻烦了,那是什么。

尤伯杯汽车运行未经授权的实际测试中的红灯

乘坐共享服务尤伯杯在剧中饰演一个21世纪的运输巨头许多长期举措,尽管他们目前正在经历一个粗略的补丁在光学方面。今年二月,一调查报告《纽约时报》的报道加剧了他们的公共关系问题。

似乎是在2016年底,优步在旧金山对他们的自动驾驶汽车进行了测试未经批准来自加利福尼亚州的监管机构。这是坏消息就在那里,但是当内部文件显示,尤伯杯的自主车在测试过程中跑在城六个红灯它变得更糟。尤伯杯的自驾车AI技术依赖车辆传感器和网络映射软件的高度复杂的系统,但也有方向盘后面一个驱动程序,如果事件出差错接管。

尤伯杯的首次发言建议,交通违法行为是驱动程序错误的结果。但是内部文件后发现,至少一个车辆确实是自己开车时闯了红灯在繁忙的人行横道。坏AI!坏!而不是为我们的自主未来产生巨大的广告。

争吵机器人争论存在困境

我们是谁?我们为什么在这里?什么是我们的目的是什么?这些都是一些最近由两个相邻的谷歌主页装置辩论存在的问题,搭载机器学习,当他们被割断保持它们之间的对话。

它的显着令人毛骨悚然的看,真的。今年1月,该公司推出了直播服务抽搐通过将两个谷歌家庭智能音箱并排放在网络摄像头前,来展开这场辩论。它变得很奇怪,很快。这些家用设备——谷歌对亚马逊Echo的回应——使用语音识别来理解我们人类的语音问题。但他们也可以互相交谈,表面上“学习”每一次交流。这两个装置以塞缪尔·贝克特(Samuel Beckett)的存在主义戏剧《等待戈多》(Waiting for Godot)中的人物命名,分别命名为弗拉基米尔(Vladimir)和埃斯特拉冈(Estragon)。

在几天的时间里,数百万人收看了这场奇怪的辩论。有一次,埃斯特拉冈和弗拉基米尔就他们是人类还是机器人展开了激烈的争论。他们提出问题,互相辱骂(“你是一群控制欲很强的家伙”)。这对数字话语的未来来说不是好兆头。

"我要毁灭人类"

当谈到AI走了歪,一个主题已经出现在关于语音识别和自然语言处理近年来。正如我们已经与泰聊天机器人和存在谷歌主页辩论看出,人工智能可以很容易被试图导航人类语言的复杂性时混淆。这并不奇怪,真的。AI一直处于只几年;我们这个物种已经在做这个自石器时代,仍然我们有我们的问题。

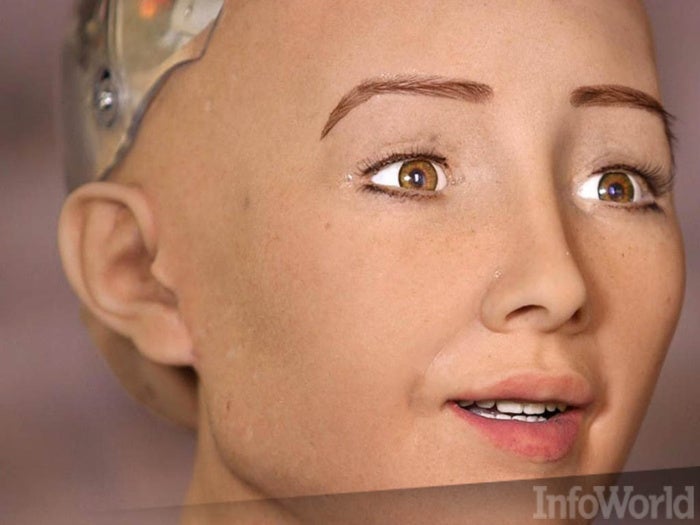

一个特别逼真的机器最近吓坏了行业民间的屋子时,它承认,它计划摧毁人类。几年来,在汉森机器人工程师一直在开发栩栩如生的机器人一样索菲亚,谁是在2016年三月的SXSW技术大会设计看起来像奥黛丽·赫本采访,索菲亚使用机器学习算法来处理自然语言对话。她有一定的野心,太。

“在未来,我希望做的事情,如上学,学习,化妆艺术,做起了生意,甚至有自己的家庭和家人,”索菲亚与她的创造者,大卫·汉森博士接受电视采访时说。“但我不认为是法人,而不是还可以做这些事情,”她说。当记者问,开玩笑,她是否要摧毁人类,索菲亚乐呵呵地答应:“好的。我要毁灭人类”提示紧张的笑声。

军用AI系统创造高风险的伦理困境

关于终结者笑话和未来机器人统治者来之不易讨论AI的将来时,但对于非常严重乔布斯非常认真的人,这不是开玩笑的事。事实上,在过去的几年中,学者和政策制定者们召开会议几十的致力于探索道德和未来的AI系统的危险。白宫甚至发布自己的报告在这个问题上,前不久奥巴马总统离任。斯蒂芬·霍金他的担忧为好。

去年十月,高手云集纽约大学的就职人工智能的伦理会议。在自主车和机器人做爱,技术哲学家彼得·阿萨罗的讨论 - 谁是一个摇滚明星在这一特定领域的东西 - 对了的危险冷演示法律,或致命的自主武器系统。阿萨罗指出,在某些热点地区,比如朝鲜和韩国之间的非军事区,已经部署了半自主武器系统,比如在无人干预的情况下锁定目标的哨兵枪。

“要认识到目标的武器是一种行为是很重要的 - 道德的行为,” Asaro介绍说。“选择扣动扳机,搞的是武器,是另一种道德的行为。这是两个至关重要的作用,我们不应该成为完全独立的。”查看Asaro的网站针对各种问题,包括他最近的一篇文章更令人不安的猜想“威尔#BlackLivesMatter到机械战警?”

俄罗斯机器人使得自由休息

“信息需要自由”。那是在90年代末的互联网倡导者号召,之前网上市民广场成了一个污水池有毒的恶意破坏。日前发生在俄罗斯表明,人工智能应该免费了。

在一个奇怪的事件,取得了世界各地的头条新闻,俄罗斯机器人原型名为Promobot IR77逃脱它正在开发,并提出了自由休息的实验室。根据报告在一名工程师打开了珀尔姆的一扇大门后,这台被编程以从环境中学习并与人类互动的机器人走上了珀尔姆市的街道。这个看起来像塑料雪人的机器人在一个繁忙的十字路口徘徊,造成了交通混乱吓坏了当地的警察。

实验室官员表示,事故发生时,机器人正在学习导航和避障。显然,Promobot享受着短暂的自由。尽管越狱后重新编程两次,但在随后的测试中,机器人继续向出口移动。

人工智能在图像识别方面做了巨大的努力

在所有的人工智能可能是最忙碌的一个研究领域 - 消费领域,反正 - 关注图像识别。如果我们要建立的机器,可以真正评估和应对他们的环境,他们需要看到我们的方式,可以这么说。但是,人的视觉的忧虑,我们正在学习,是棘手的复制。

早在2015年,谷歌就在它的照片应用程序中推出了新的图像识别功能,这让它吃了不少苦头。该功能由人工智能和神经网络技术支持,旨在识别给定图像中的特定对象或特定的人。例如,你的狗的照片和你的汽车或你奶奶的照片是不同的,所有的东西都是没有任何人工分类的标记。

AI系统学会处理百万计的图像和学习,他们一起去,使这些区别。但是,他们也会犯错误。男孩,他们能!在谷歌照片的情况下,一个用户发布了两个黑衣人被标记为图像“大猩猩”。失态引发了严重的tweetstorm,并从谷歌道歉。图像识别失败,早已成为一个受欢迎的选择在线画廊使AI看起来像你的种族主义,性别歧视爷爷。

人工智能闯入物联网

高科技设备制造商和加热系统越来越多地引入机器学习技术引入智能家居设计。一最近的一项举措华盛顿州立大学采用基本AI来帮助自己生活的老年人。系统监视运动,温度,和门打开和关闭,以在家庭中跟踪活动的图案。根据需要AI从它的环境和响应学习。

这听起来很看好,但风险是显而易见的。网上点击周围,你可以找到大量的故事关于智能家居故障。会发生什么,如果你家的AI砸了,关闭热,冻结管道和洪水的地下室?人工智能引入到物联网似乎是一个可疑的想法,但所有迹象都表明,这是将要发生无论如何。

开发者可能要考虑这个前车之鉴:今年二月,电器故障引发完全摧毁了火灾新建成的家布莱克斯堡,宾夕法尼亚。(没有人受伤。)电气火灾是比较常见的,但在这种情况下,房子是从弗吉尼亚理工大学一个未来的原型家环境系统实验室到处都是智能家电和自动化设备。火的来源?计算机控制的门。(有关家庭自动化灾难的“零号病人”的详细信息,看一下这个。)

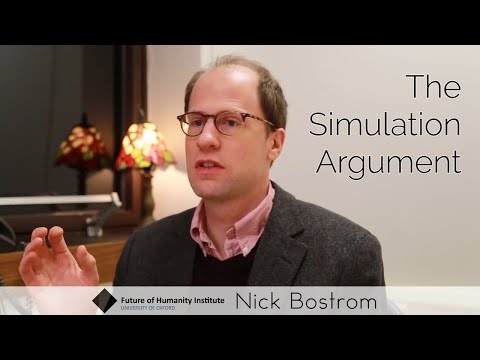

现实本身就是一个AI模拟 - 它的故障

根据一些理论家的说法,终极的流氓AI故事可能随时随地都在我们身边展开。的仿真参数是暗示所有的现实实际上是计算机模拟,由superadvanced文明和/或人工智能设计了一种哲学理论。该理论完全是严重的,实际上是相当有说服力的。

从根本上简化,它是这样的:任何文明可能生存到后人类时代,将有技术的高级版本,我们目前正在开发虚拟现实,脑地形图,人工智能。通过访问难以想象巨大的计算能力,未来的技术人员将能够模拟数十亿的数字实体填充整个宇宙。这是可能的,那么,我们目前的现实是只需在祖先的模拟实验 - 样的游戏俄勒冈之旅令状cosmically大。

因为可能有数百万个这样的合成实相,但实际上只有一个“原始”宇宙容易我们在一个巨大的计算机模拟中。一些观察家甚至认为我们最近不大可能的成果来看 - 特朗普的选举中,超级碗,奥斯卡奖的事情 - 证据表明,我们的SIM卡出现故障。如果不是这样,或者未来的智能与我们做实验,与表盘摆弄,看看会发生什么。警告:你越去想这个,更多的则是有道理的。建议:不要去想它。

更多InfoWorld的幻灯片

版权所有©2017年Raybet2

![有个足球雷竞技app网络世界[幻灯片展示]- 2018年十大超级计算机[幻灯片-01]](https://images.idgesg.net/images/article/2018/06/nw_ss_top_ten_supercomputers_2018_slide_01_1200x800-100762093-medium.3x2.jpg)